自适应提升算法(AdaBoost)

一个集合了若干弱学习器并适应每个训练样本“难度”的集成元算法。

输入

- 数据:输入数据集

- 预处理器:预处理方法

- 学习器:学习算法

输出

- 学习器:adaboost 学习算法

- 模型:训练过的模型

功能

AdaBoost,自适应增强(Adaptive boosting)的缩写, 是一种机器学习算法,由Yoav Freund and Robert Schapire提出。它可以与其他学习算法一起使用以提高其性能。这通过调整弱学习器来实现。 自适应提升算法(AdaBoost) 适用于分类和回归。

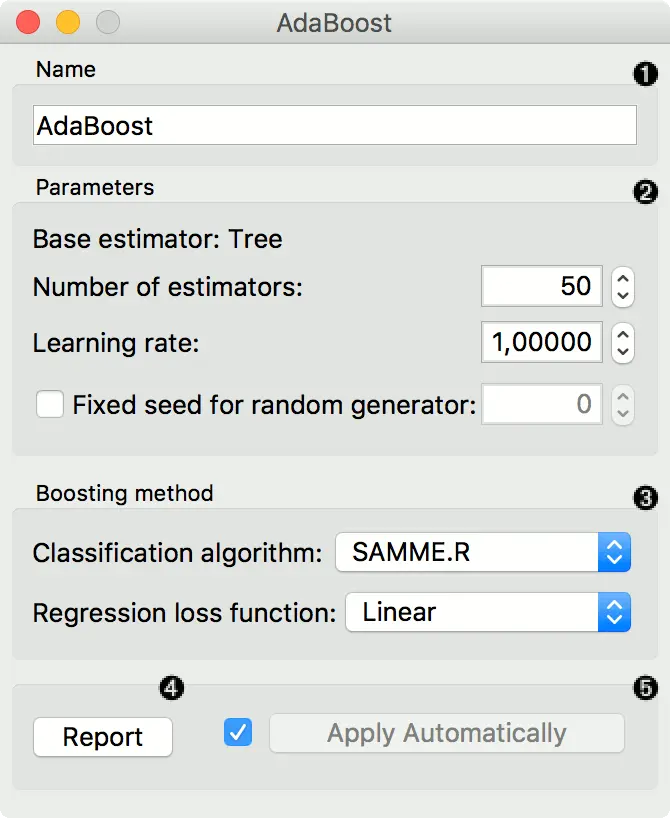

界面

- 可以给学习器一个名称,该名称将出现在其他小部件中。 默认名称是“自适应提升算法(AdaBoost)”。

- 设置参数。 基学习器树,您可以设置:

基学习器数目学习率:它确定新获取的信息将在多大程度上覆盖旧信息(0表示学习器将不学习任何信息,1表示学习器仅考虑最新信息)随机发生器的固定种子:设置一个固定种子,以重现结果。

- 提升方法。

分类算法(如果是分类问题):SAMME(使用分类结果更新基本估计量的权重)或SAMME.R(使用概率估计更新基本估计量的权重)。回归损失函数(如果是回归问题):线性,平方,指数。

- 发送报告

- 勾选 “自动应用” 以自动传送对其他小部件的更改,并在连接学习数据后立即训练分类器。 或者,在配置后按 “应用”。

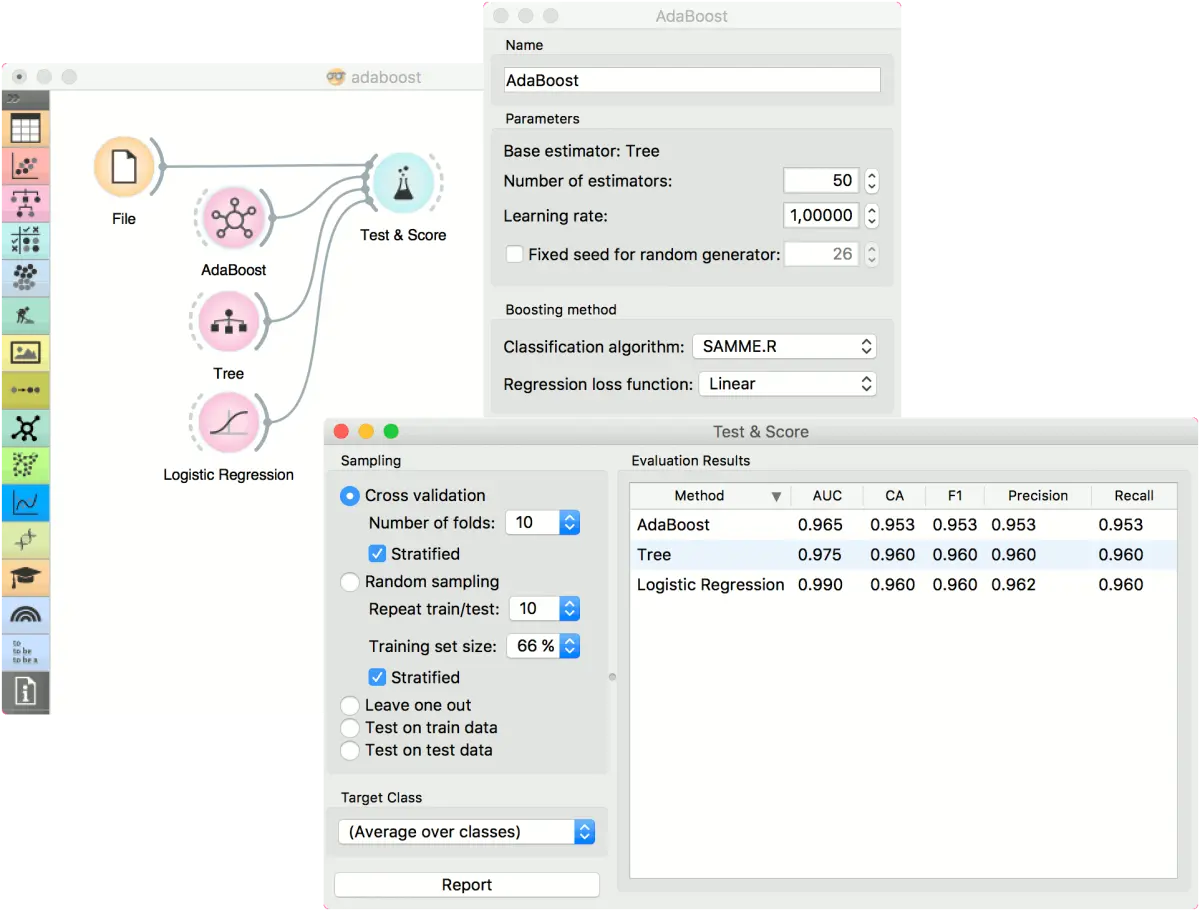

示例

为了进行分类,我们加载了 iris 数据集。 我们使用自适应提升算法(AdaBoost) ,树(Tree)和逻辑回归(Logistic Regression),并在测试与评分(Test & Score)查看与比较结果。

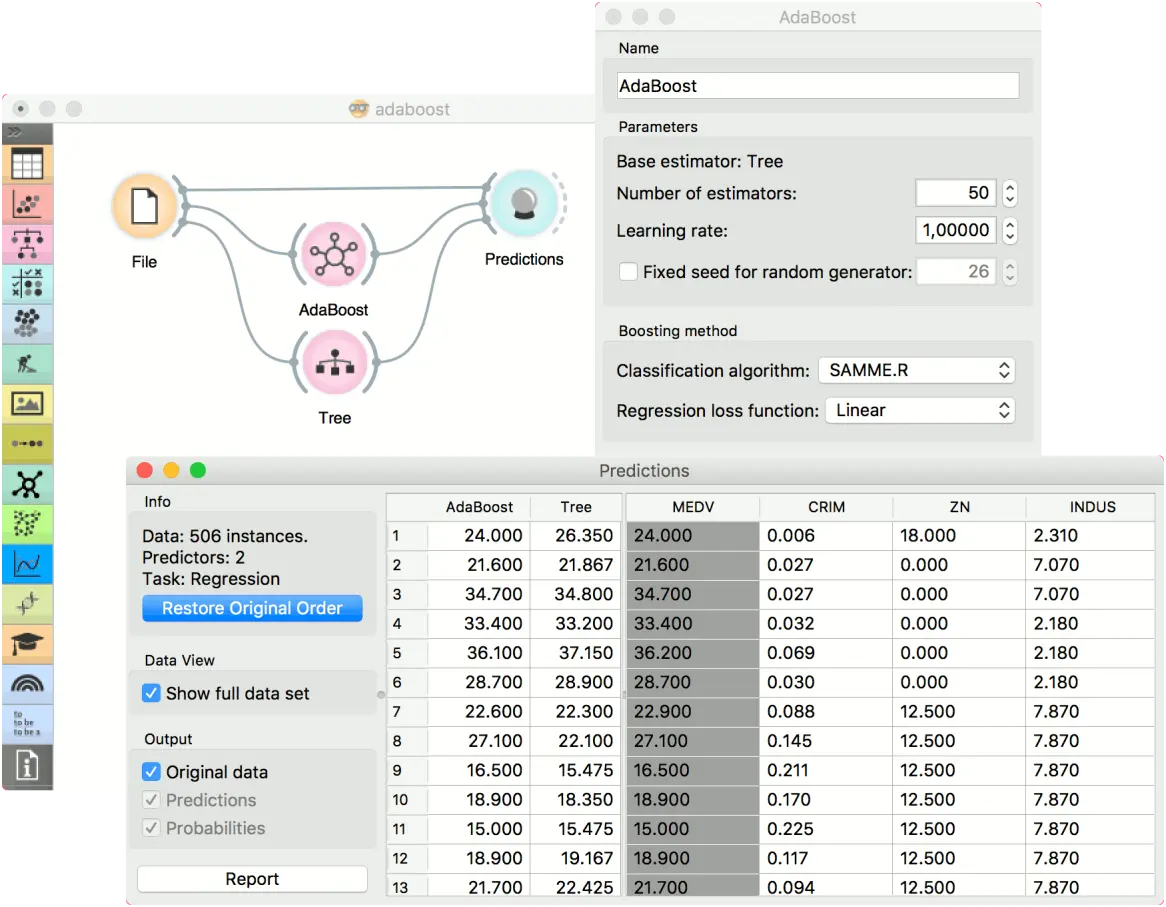

为了进行回归,我们加载了 housing 数据集,将数据实例发送到两个不同的模型: 自适应提升算法(AdaBoost) ,树(Tree),并将它们输出到预测(Predictions)小部件。

反馈问题

文档有问题? 或者有其他意见和建议? 请在本文档的 Github 仓库直接反馈

点我反馈进入反馈页面不知道如何反馈, 请点击这里